검색엔진 최적화는 홈페이지는 돈 없이 홍보하기 좋은 방법중 하나라고 한다.

검색엔진 최적화가 되어 있는 홈페이지와 그렇지 않은 홈페이지는 검색엔진에 더 많이 노출될 수 있다.

필자의 경우 홈페이지를 만들었는데, 검색이 잘 되지 않아 알아보니 검색엔진 최적화 중 robots.txt를

세팅하지 않았다는 것을 인지하게되었다.

이를 설정해 놓으면 각각의 검색 엔진들이 이를 크롤링해서 검색에 더 욱더 유리해진다

robots.txt 문법은 간단하다

모든 검색봇에 대해 모든 것을 허용

User-agent: *

Allow: /

모든 검색봇에 /auth를 제외하고 허용

User-agent: *

Disallow: /auth

Allow: /

회사 별 검색로봇 명칭

각 회사별 검색로봇의 이름이 다른다.

네이버 : Yeti

구글 : Googlebot

빙 : Bingbot

다음 : Daum

네이버 웹마스터 도구

네이버 웹마스터 도구에서는 검색 네이버전용 robots.txt를 만들어 준다.

사이트 관리를 들어간 후 좌측에 검증을 클릭하면 robots.txt 항목을 볼 수 있다.

robots.txt 간단 생성란을 발견할 수 있다.

생성된 robots.txt 파일은

자신의 홈페이지/robots.txt 로 검색 되게 root쪽에 파일을 두면 된다.

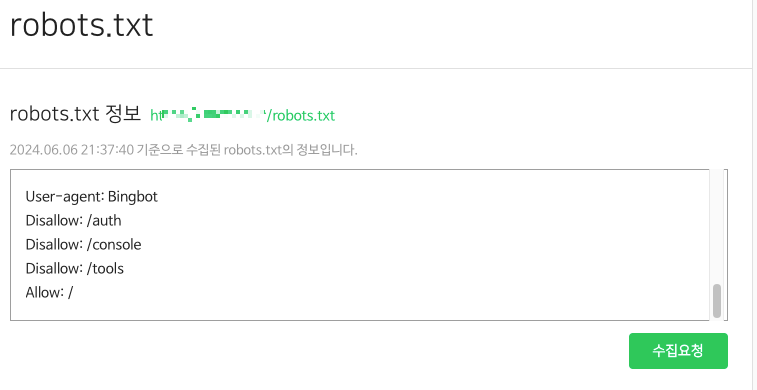

그 뒤 robots.txt 검증 > robots.txt 정보 수집요청을 클릭하면

자신이 설정해 놓은 robots.txt 파일을 그대로 수집해오는 것을 볼 수 있다.

이러면 robots.txt 설정 끝!

번외 네이버 웹마스터에서 URL 검사

검증 > URL 검사 > 자신의 홈페이지 입력 후 확인 클릭 아래와 같이 추가 설정을 해야하는 것들을 알려준다!

필자는 description이 필요하다!

댓글